Inhaltsverzeichnis

Daten waren schon immer das A und O in der Informationstechnik. Heute reden wir schon fast von einem Datenmangel. Es gibt scheinbar nicht genug abgreifbare Daten um die KI Modell noch größer und besser zu machen. Daher muss man versuchen den KI Modellen andere Datenquellen über Dienste zugreifbar zu machen. Auch wird es immer wichtiger, dass eine KI externe Dienste ausführen kann um Prozesse anzustarten.

Hier kommt das Model Context Protocol (MCP) ins Spiel – ein offener Standard, der nicht nur die Interaktion zwischen Sprachmodellen (LLMs) wie Claude, ChatGPT, Mistral, ... ermöglicht, sondern auch eine wirkliche Evolution in der Art und Weise darstellt, wie wir KI-Anwendungen nutzen.

Ein einheitlichen Protokoll

Im Podcast "The Creators of Model Context Protocol" haben die Entwickler von Anthropic die Motivation hinter MCP ausführlich erörtert. Das Protokoll wurde mit der Überzeugung entwickelt, dass es einen einheitlichen Standard benötigt, um die Integration von Künstlicher Intelligenz in verschiedene Systeme zu vereinfachen. Es ist wie ein "USB-C-Port" für KI, der eine standardisierte Schnittstelle für den Zugriff auf Funktionen und Daten bereitstellt.

Das bedeutet, dass wir nicht nur Informationen abrufen können, sondern auch Aktionen ausführen und komplexe Aufgaben bewältigen – eine spannende Aussicht für Entwickler und Unternehmen, die auf der Suche nach effizienten Lösungen sind. Besonders in heterogenen IT-Landschaften, in denen verschiedene Systeme, APIs und Datenquellen aufeinander treffen, wird ein solches Protokoll zum echten Gamechanger.

Wer einen guten deutschsprachigen Überblick über das Protokoll möchte, kann sich auch die sehr informative Podcastfolge MCP – Model Context Protocol

Der Universalstecker für KI-Modelle von Innoq anhören.

MCP Server erlauben es einem Agent auf Tools zuzugreifen. Der MCP-Server kann einem Agenten standardisiert eine Liste der verfügbaren Tools bereitstellen. Zudem wird der Context des LLM zwischen den MCP-Servern ausgetauscht.

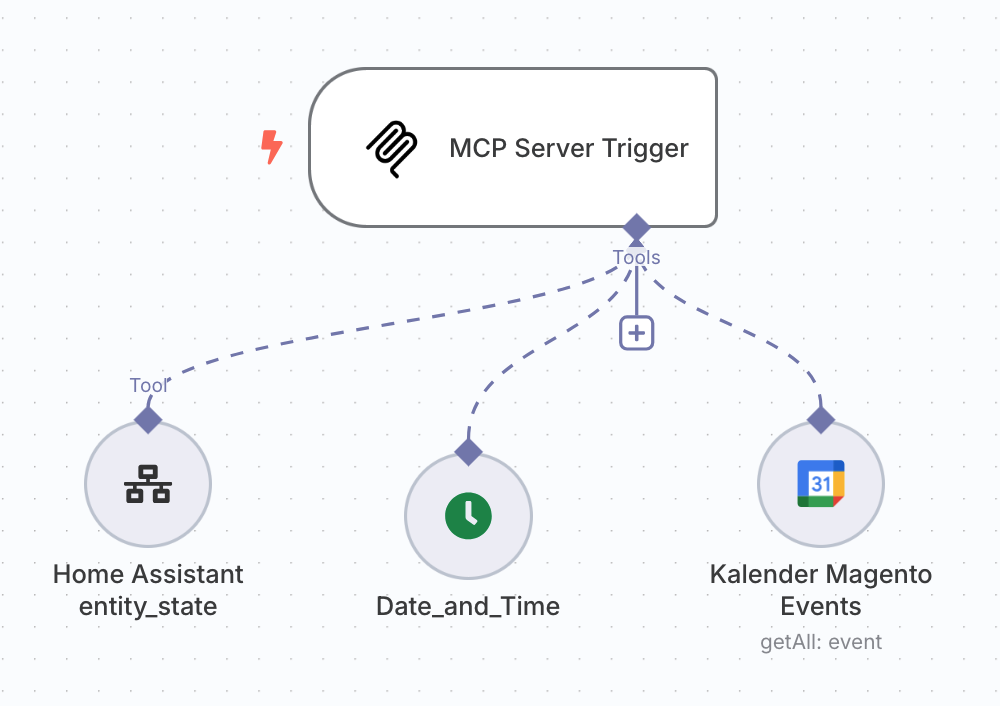

MCP in der Praxis: Integration mit n8n

Ein hervorragendes Beispiel für die praktische Umsetzung von MCP ist die Integration in n8n, einem Open-Source-Werkzeug zur Workflow-Automatisierung. Mit den neuen Nodes MCP Client Tool und MCP Server Trigger können Benutzer nun sowohl MCP-Clients als auch -Server erstellen. Dies öffnet die Tür für die Entwicklung von innovativen Workflows, die nahtlos mit LLMs interagieren und externe Dienste integrieren.

Stellen Sie sich vor, Sie richten einen MCP-Server in n8n ein, der auf Google Calendar zugreift. Das ermöglicht nicht nur das Abrufen von Terminen, sondern auch das Erstellen und Verwalten von Veranstaltungen – alles automatisiert und ohne großen Aufwand. Ebenso denkbar sind Szenarien, in denen ein LLM automatisch Verträge analysiert, Kundendaten aggregiert oder Ticketsysteme intelligent befüllt – alles orchestriert über n8n und MCP.

Einfacher MCP-Server in Python

Wer schneller und effizienter MCP-Server entwickeln möchte, findet in FastMCP 2 ein ideales Framework. Dieses bietet die Möglichkeit, MCP-Server und -Clients mit minimalem Boilerplate-Code zu erstellen. Entwickler können so Ressourcen schneller bereitstellen und Komponenten verknüpfen, ohne sich in endlosen Konfigurationen zu verlieren.

Diese Einfachheit erleichtert nicht nur den Einstieg, sondern macht MCP auch für kleinere Projekte und MVPs attraktiv. Mit FastMCP lassen sich auch komplexere Funktionalitäten wie Authentifizierung, Datenbankanbindung oder Drittanbieter-APIs integrieren.

Ein einfaches Beispiel für die Verwendung von FastMCP könnte wie folgt aussehen. In diesem Beispiel wird die API meiner eigenen Wetterstation aufgerufen:

from fastmcp import FastMCP

import requests

# Create an MCP server

mcp = FastMCP("WeatherStation")

# Add a weather resource

@mcp.resource("weather://current")

def get_current_weather() -> dict:

"""Fetch current weather data from the private Wetterstation API"""

response = requests.get("https://api.muench.dev/v1/weatherstation/current")

response.raise_for_status()

return response.json()

# Add a tool to get temperature in Celsius and Fahrenheit

@mcp.tool()

def get_temperature() -> dict:

"""Fetch the current temperature in Celsius and Fahrenheit"""

data = get_current_weather()

celsius = data.get("temperature_C")

fahrenheit = (celsius * 9/5) + 32 if celsius is not None else None

return {"temperature_C": celsius, "temperature_F": fahrenheit}

if __name__ == "__main__":

mcp.run()

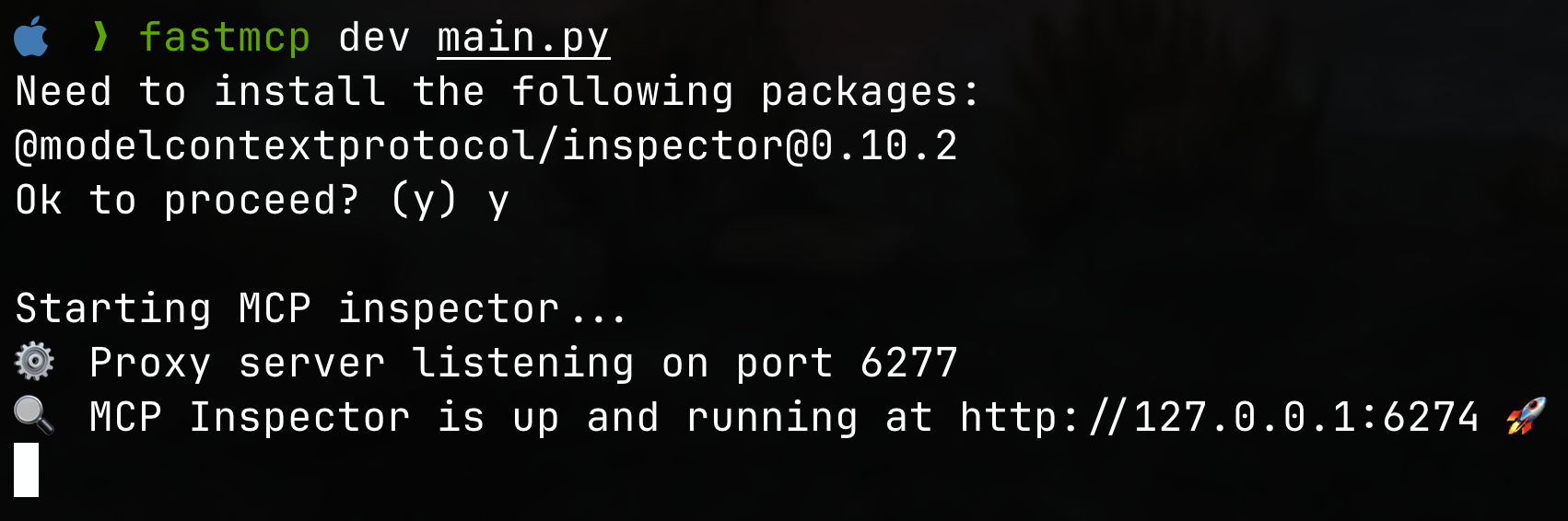

Die Ausführung erfolgt dann über fastmcp run <script> oder im Developer Mode mit fastmcp dev <script>.

Oder zum Starten eines SSE basierten Servers:

fastmcp run --transport=sse --port=8000 main.py

Der Source Code ist hier veröffentlicht: https://github.com/muench-dev/my-weatherstation-mcpserver-example

Entwickler-Tools

Für Entwickler bieten Tools wie der MCP Inspector und Multi-MCP wertvolle Möglichkeiten, die Kraft des MCP zu entfalten.

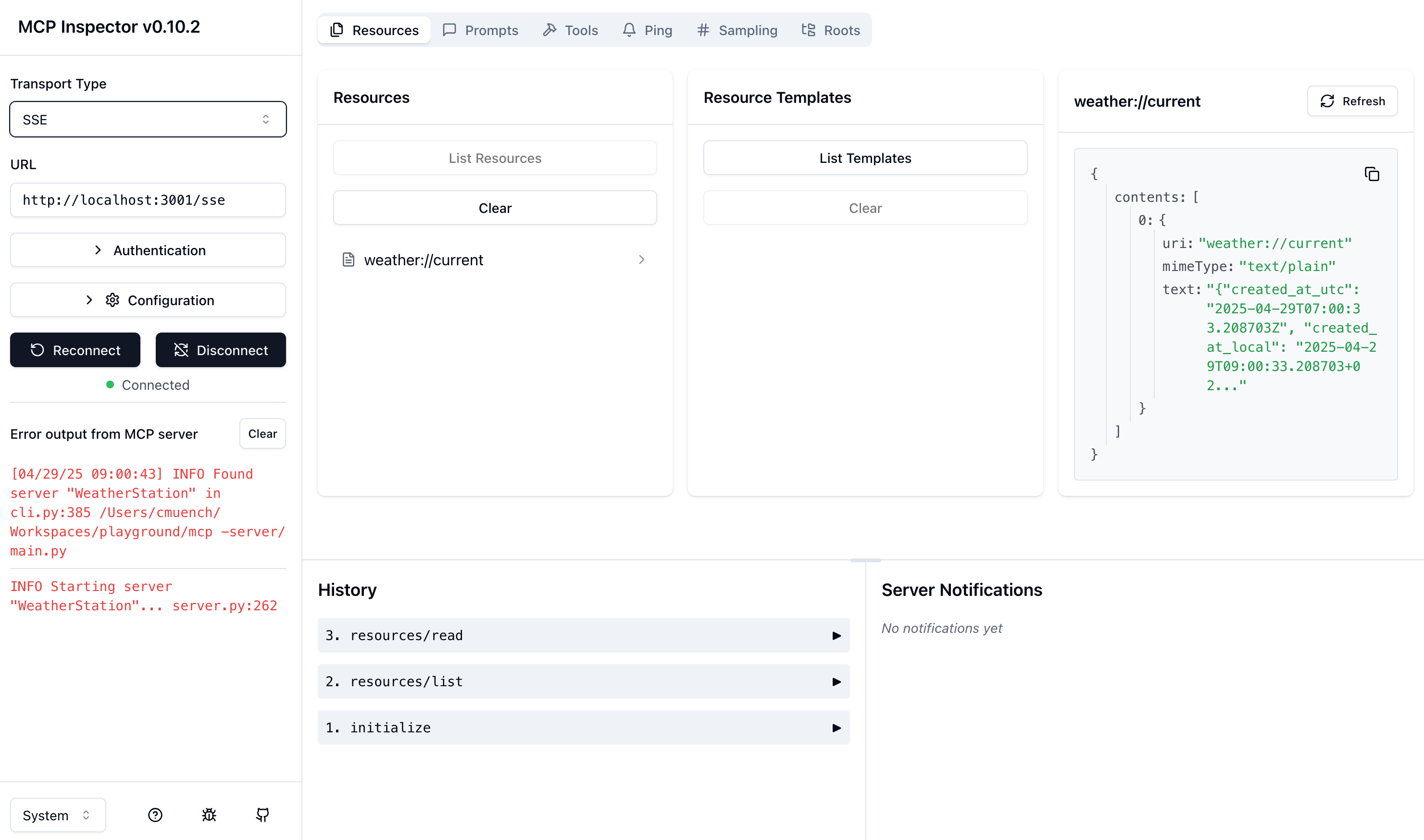

MCP Inspector

Der MCP Inspector ist ein interaktives Tool, das das Testen und Debuggen von MCP-Servern erleichtert. Mit einer benutzerfreundlichen Oberfläche können Entwickler die Funktionalität ihrer Server überprüfen und analysieren – ein Muss für jeden Entwickler, der sicherstellen möchte, dass seine Lösungen einwandfrei funktionieren.

Multi MCP / MCP Proxy

Multi-MCP hingegen fungiert als flexibler Proxy-Server. Dieser kann als einzelner MCP-Server agieren, während er mit mehreren Backend-MCP-Servern kommuniziert. Damit bieten sich neue Dimensionen der Flexibilität – ein Gewinn für jeden Entwickler, der modular arbeiten möchte.

Zum Beispiel kann ein Multi-MCP-Setup verwendet werden, um Anfragen an verschiedene spezialisierte Backend-LLMs zu routen – etwa ein Modell für juristische Fragestellungen, ein anderes für medizinische Auskünfte und ein drittes für kreative Texte. Der Endnutzer interagiert nur mit einem Interface – die Komplexität bleibt im Hintergrund verborgen.

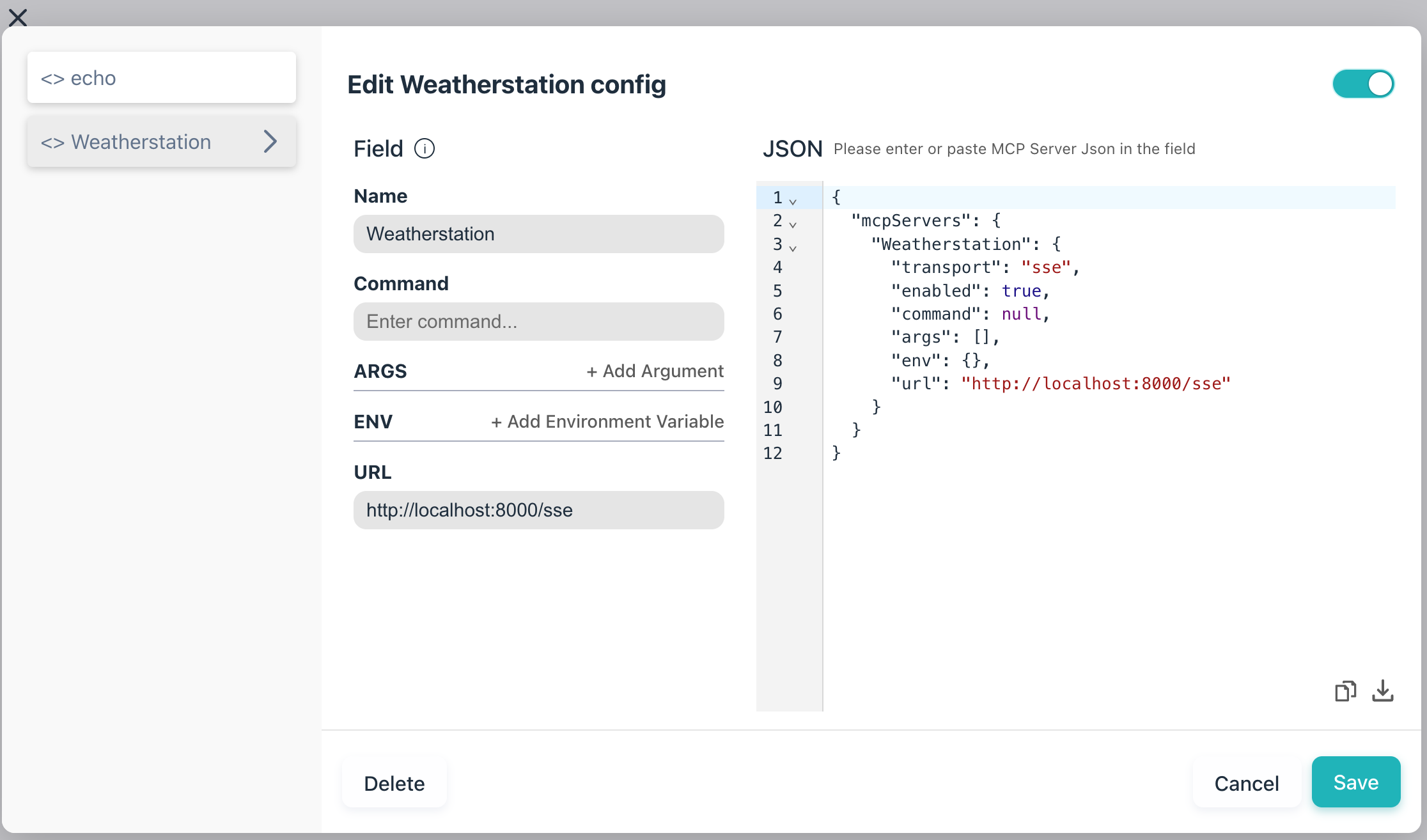

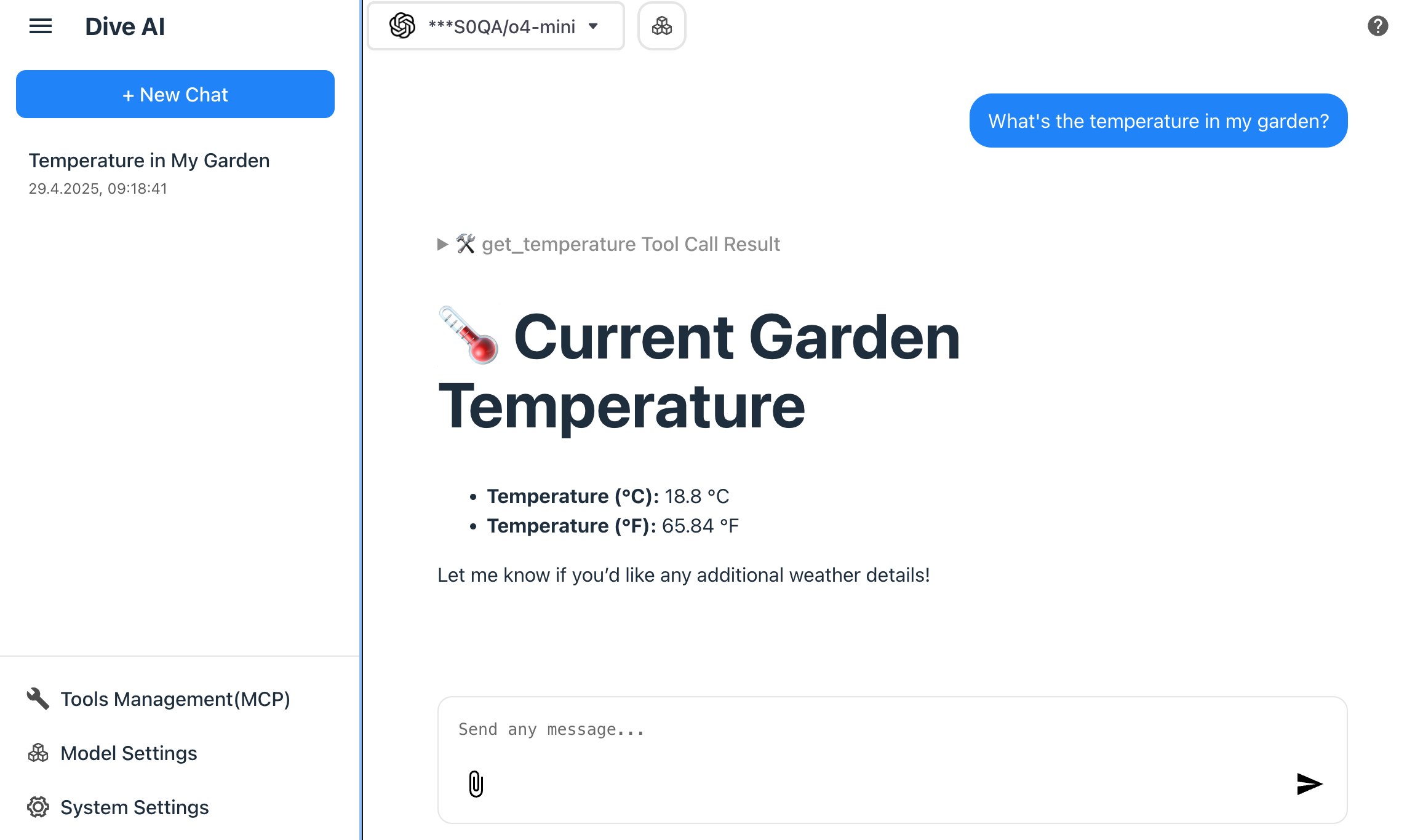

Dive

Schnell testen und integrieren lassen sich MCP Server mit dem Tool Dive AI Agen, was für alle großen Betriebssysteme zur Verfügung steht. Hier lassen sich über eine einfache Konfiguration schnell mal MCP Server integrieren und direkt testen.

Über eine gewohnte Oberfläche lassen sich dann Prompts formulieren.

Dive kann auch die Ein- und Ausgaben des aufgerufenen Tools der genutzten MCP Server anzeigen.

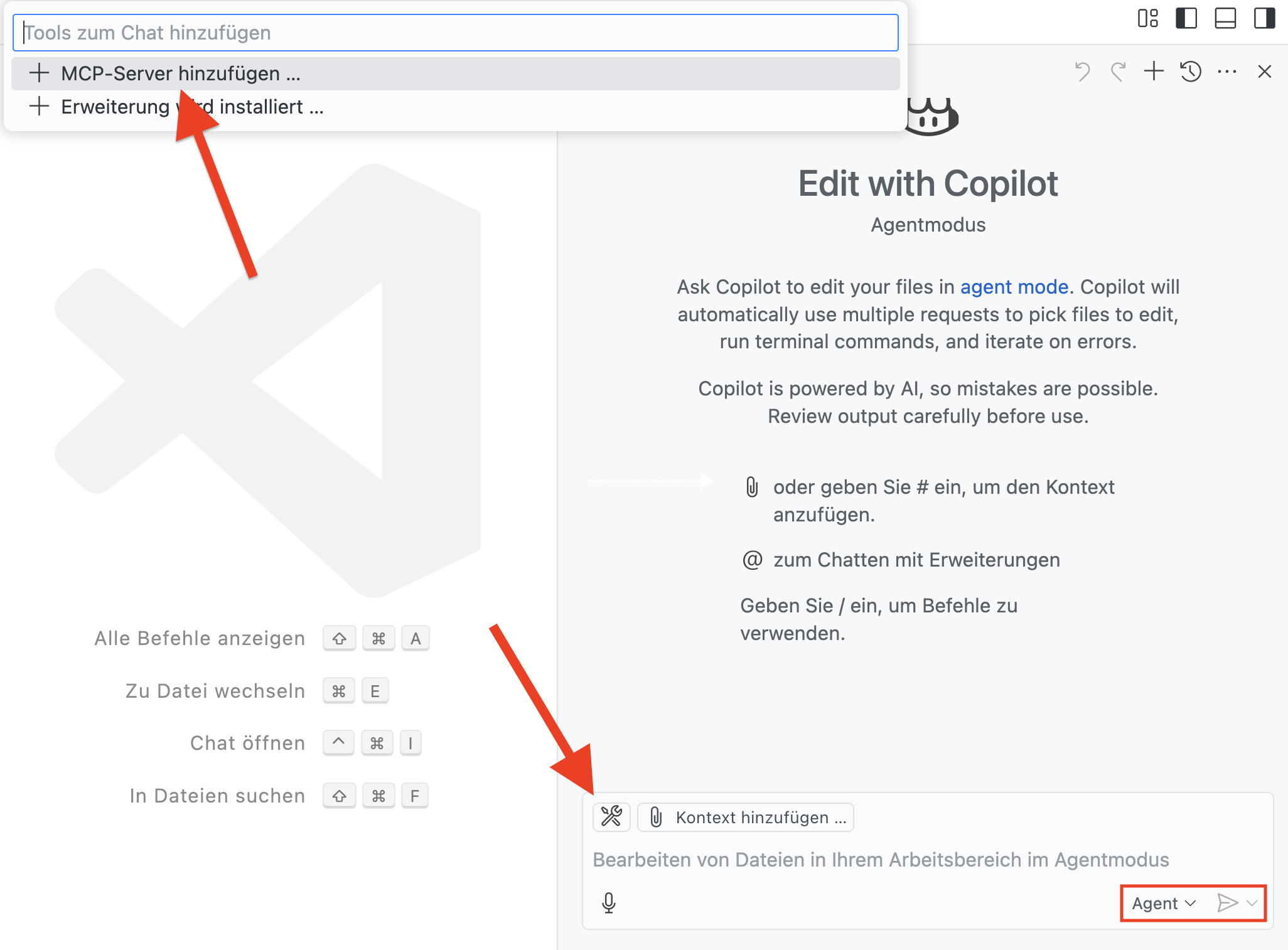

Microsoft Visual Studio Code mit GitHub Copilot

Visual Studio Code (VS Code) ist eine der beliebtesten Entwicklungsumgebungen, die durch zahlreiche Erweiterungen angepasst werden kann. Eine dieser Erweiterungen ist GitHub Copilot, ein KI-gestützter Programmierassistent. Standardmäßig kommuniziert Copilot mit den Servern von GitHub. Es ist jedoch möglich, die Erweiterung so zu konfigurieren, dass sie stattdessen Tools aus eigenen MCP- Server nutzt. Der MCP-Server lässt sich

Standardisierung und Interoperabilität

Die Stärke von MCP liegt nicht nur in der Technologie selbst, sondern auch in der Vision, die dahintersteht. Durch die Schaffung eines offenen Standards wird Interoperabilität gefördert – nicht nur zwischen Modellen und Clients, sondern auch zwischen Unternehmen, Plattformen und Communitys.

Langfristig könnte MCP sogar zu einem zentralen Bestandteil moderner Softwarearchitekturen werden – vergleichbar mit REST oder GraphQL. Stellen Sie sich ein digitales Ökosystem vor, in dem jedes Modul, jede Anwendung und jede KI-Komponente über ein gemeinsames Protokoll kommuniziert. Das spart nicht nur Zeit und Ressourcen, sondern erhöht auch die Zuverlässigkeit und Skalierbarkeit von Systemen.

Interessant ist in diesem Zusammenhang, dass Google mit dem A2A-Protokoll (Agents-to-Agents) eine eigene Antwort auf MCP vorgestellt hat. In dem Artikel "A2A and MCP: Start of the AI Agent Protocol Wars?" (https://www.koyeb.com/blog/a2a-and-mcp-start-of-the-ai-agent-protocol-wars) wird diese Entwicklung eingehend beleuchtet. Obwohl A2A einen ähnlichen Anspruch verfolgt, lässt sich bereits erkennen, dass selbst OpenAI – trotz der direkten Konkurrenz zu Anthropic – Bestrebungen zeigt, MCP zu unterstützen oder sich daran anzulehnen. Auch innerhalb der Google-Community wird diskutiert, MCP möglicherweise zu adaptieren. Diese Dynamik deutet darauf hin, dass MCP das Potenzial hat, sich als dominanter Standard in der Welt der KI-Agentenkommunikation durchzusetzen.

Fazit

Das Model Context Protocol (MCP) ist nicht nur ein weiterer technischer Standard; es ist ein Schlüssel zu einer neuen Ära der KI-Integration. Mit Tools, die Entwicklern helfen, einfachere und flexiblere Systeme zu schaffen, sowie mit der Möglichkeit, KI in bestehende Anwendungen einzubinden, stehen die Türen weit offen für innovative Lösungen.

Nutzen Sie die Kraft von MCP, um Ihre Projekte voranzubringen! Denken Sie an all die Möglichkeiten, die es bietet, und wie Sie es nutzen können, um Ihre Ideen zum Leben zu erwecken. Es ist Zeit, die nächste Generation der KI-Integration zu begrüßen – und MCP könnte einer der entscheidenden Schritte sein.

Artikel Aktualisierungen

- 30.04.2025: Abschnitt zu VS Code ithub Copilot hinzugefügt.