Inhaltsverzeichnis

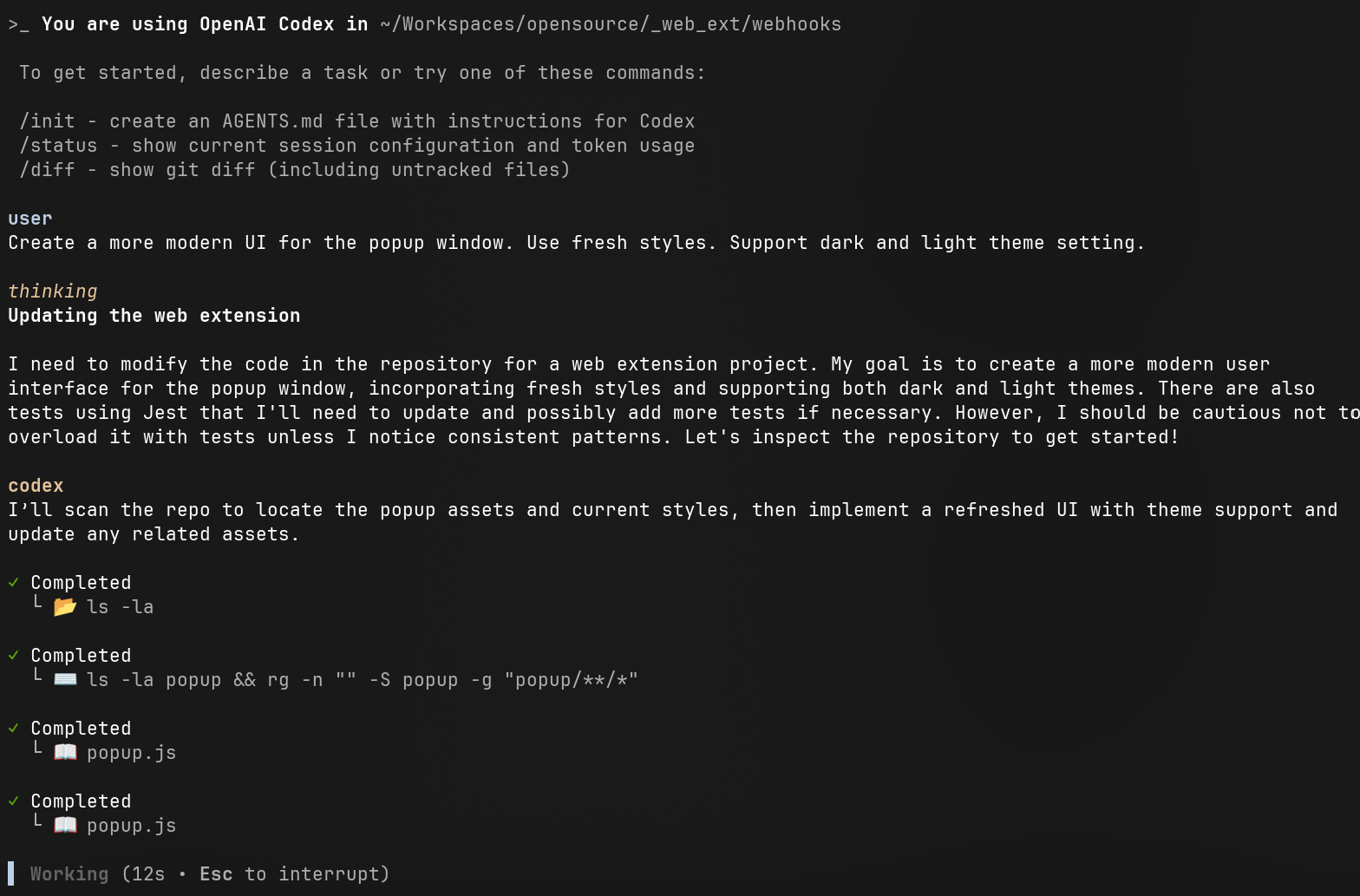

Nachdem ich bereits den autonomen KI-Coding-Agenten Codex in der Web-Version getestet hatte (Blog-Beitrag), war ich an einem Punkt etwas eingeschränkt: Der Agent konnte nur auf Projekte zugreifen, die auf GitHub gehostet wurden. Doch jetzt gibt es eine spannende Neuerung: Codex CLI. Dieses Tool ermöglicht es, den Agenten direkt im Terminal auf dem eigenen Rechner laufen zu lassen. Das habe ich mir natürlich sofort genauer angesehen.

Installation und Setup

Die Einrichtung von Codex CLI ist denkbar einfach. Auf dem Mac kann man es bequem über Homebrew installieren, alternativ steht auch npm zur Verfügung.

npm install -g @openai/codex

oder

brew install codex

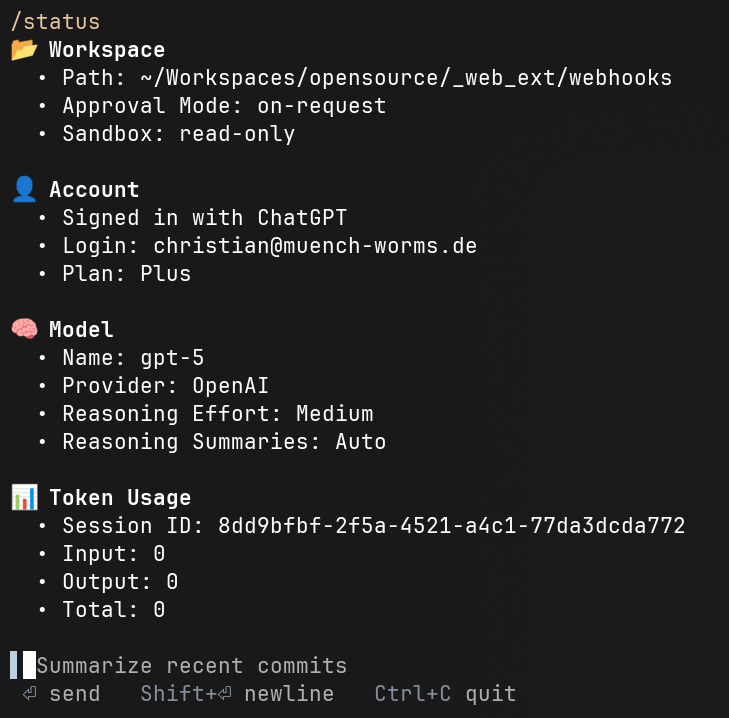

Nach der Installation muss man seinen OpenAI API Key hinterlegen. Hier hat man die Wahl: Entweder man rechnet volumenbasiert ab oder man nutzt sein bestehendes OpenAI ChatGPT Plus-Abonnement. Ich habe mich für mein Abo entschieden. Überraschenderweise konnte ich online keine genauen Informationen zu Limits, Quotas oder Session-Zeiten finden. In meinen umfangreichen Tests bin ich jedoch an keine spürbare Grenze gestoßen, was auf eine recht großzügige Regelung hindeutet.

Ein besonders spannendes Detail: In meinen Tests lief im Hintergrund bereits das GPT-5-Modell. Und um es vorwegzunehmen: Die Ergebnisse waren durchweg beeindruckend. Alle vom Agenten durchgeführten Änderungen waren nicht nur nutzbar, sondern sind teilweise bereits in produktiver Software im Einsatz.

Die erste Coding-Session

Wie startet man also das Coding mit Codex CLI? Man öffnet ein Terminal, navigiert in das gewünschte Projektverzeichnis und startet das Tool mit dem einfachen Befehl:

codex

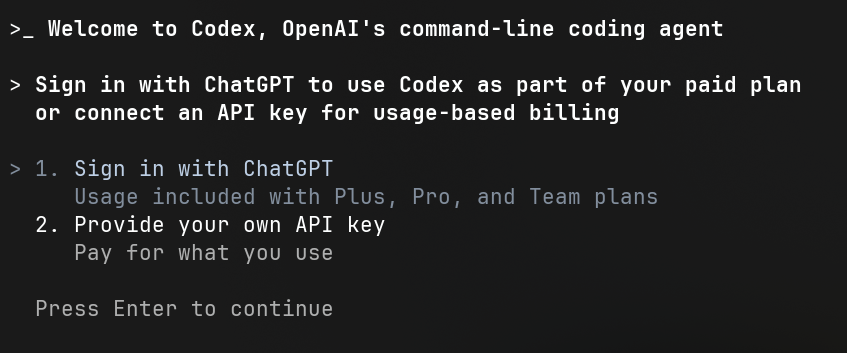

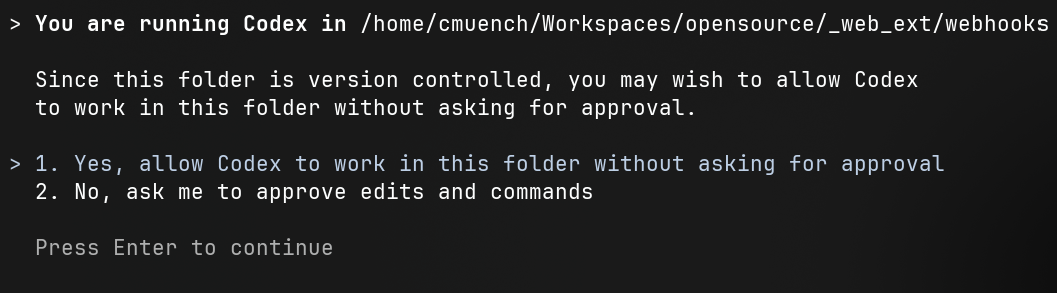

Danach folgt ein unkomplizierter, interaktiver Authentifizierungsprozess. Ich habe "Sign in with ChatGPT" gewählt, woraufhin sich ein Browserfenster öffnete, in dem ich dem Zugriff zustimmen konnte. Direkt danach war die CLI-Session bereit für meinen ersten Prompt.

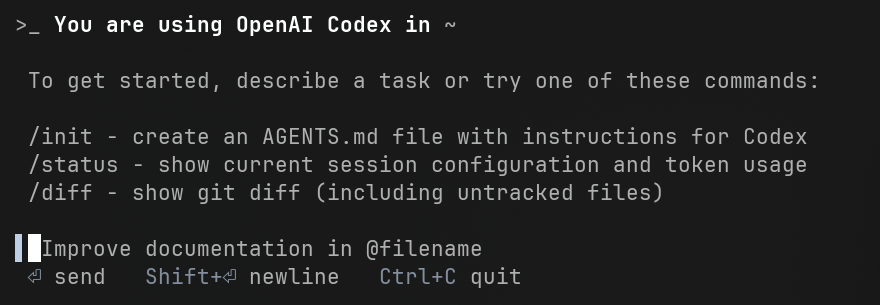

Wichtige Slash-Commands

Innerhalb einer Session stehen einige nützliche "Slash-Commands" zur Verfügung:

/init: Mit diesem Befehl kann man eine Art Systemprompt für den Agenten generieren lassen. Codex erstellt dann eineAGENTS.md-Datei. Idealerweise hat man diese Datei aber bereits vorher angelegt und dem Agenten darin schon genaue Anweisungen, Wünsche und Coding-Standards mitgegeben./status: Zeigt Informationen zum genutzten Modell und zur Auslastung des Context-Fensters an. Interessanterweise war der Context bei mir nie auch nur annähernd voll. Der Agent scheint hier sehr effizient zu arbeiten, was sicherlich auch dem GPT-5-Modell zu verdanken ist./diff: Listet alle Änderungen auf, die der Agent im Projekt vorgenommen hat.

Gibt man einfach einen Text ein und bestätigt mit Return, interpretiert der Agent dies als seine Arbeitsanweisung. Einfacher geht es kaum.

Es gibt noch mehr Slash Commands wie:

/compact: Erstellt eine Zusammenfassung des aktuellen Context und macht diesen Komapkter. Damit kann man den Context quasi neuerstellen und verkleinern./mention: Weisst den Agenten an sich eine zu definierende Datei anzuschauen./new: Startet eine neue Session mit einem neuen Kontext.

Codex in Aktion: Zwei Praxistests

Der Agent macht genau das, was man von ihm erwartet. Er protokolliert alle Schritte übersichtlich und gut formatiert im Terminal. Man kann ihn entweder autonom arbeiten lassen oder jeden Befehl einzeln bestätigen.

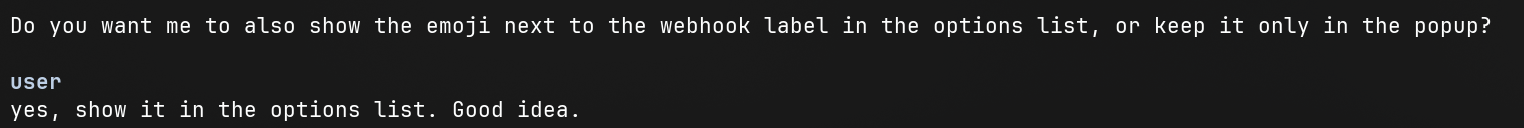

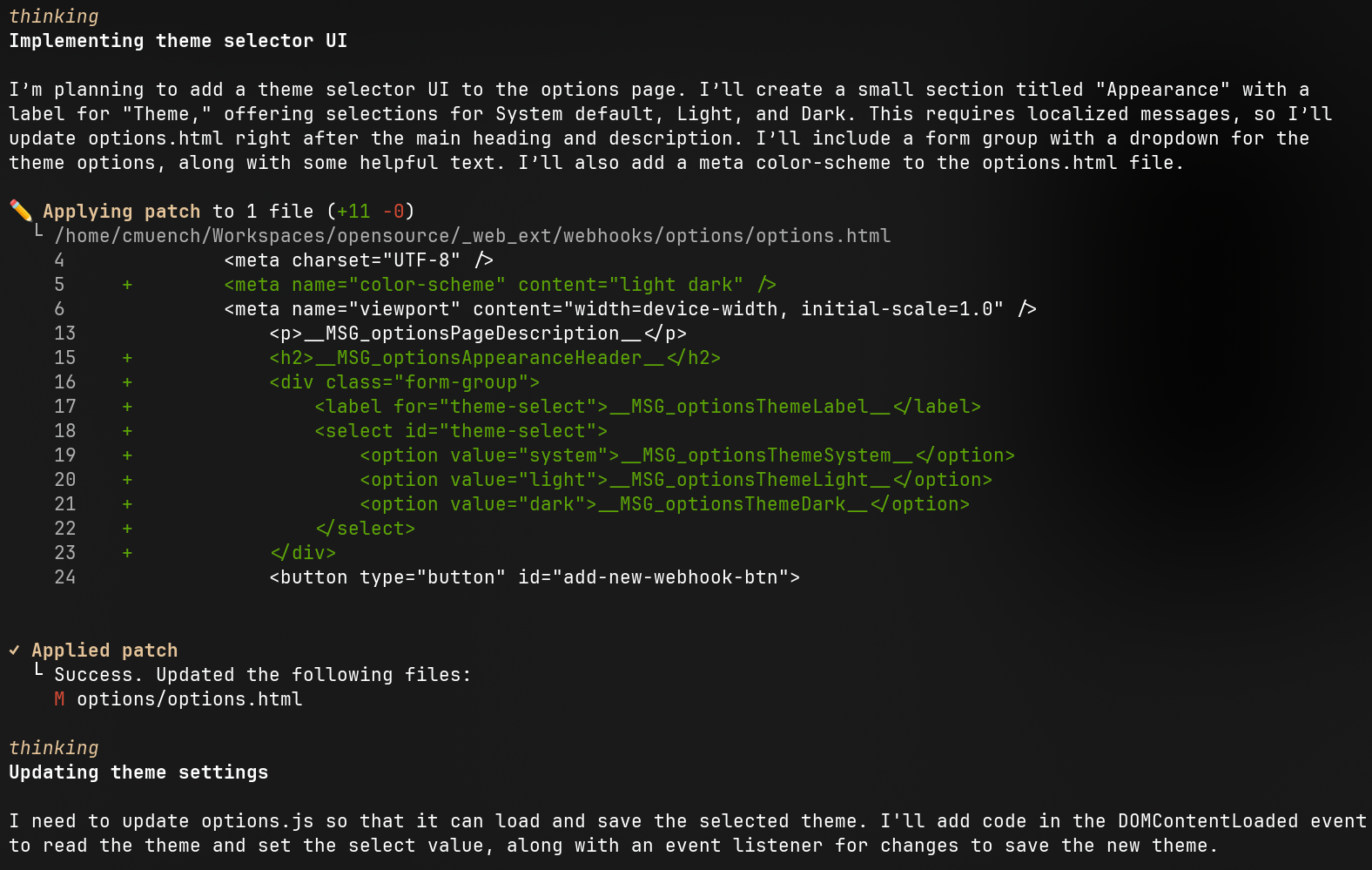

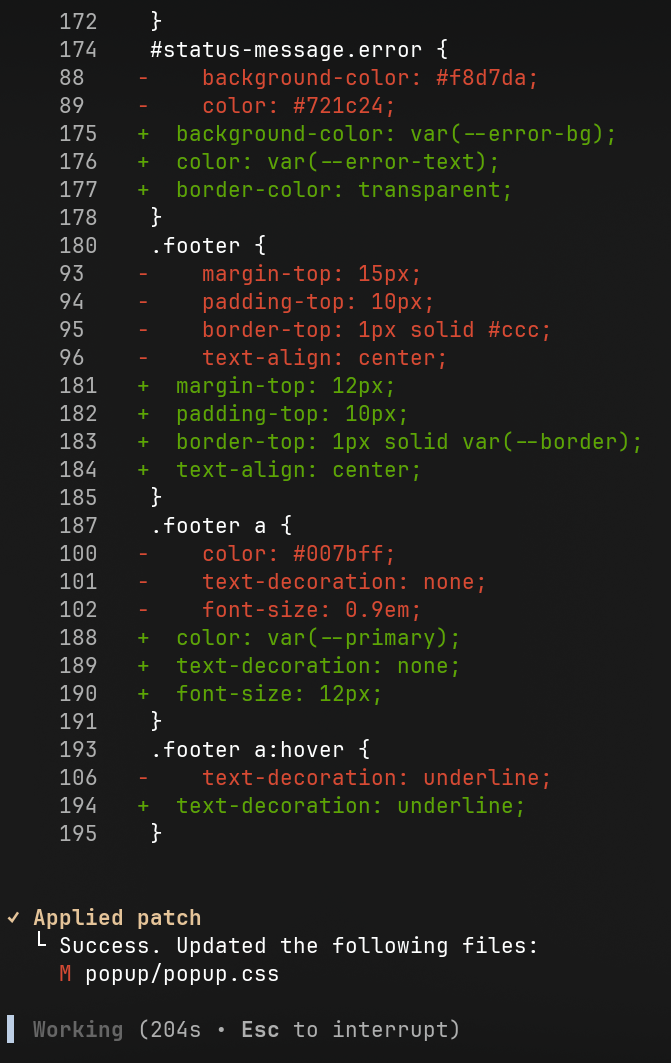

Änderungen an Dateien, ausgeführte Befehle und wichtige Diffs werden transparent dargestellt. Gelegentlich stellt der Agent sogar intelligente Rückfragen oder macht Verbesserungsvorschläge.

Erkannte Fehler versucht er selbstständig zu beheben, was in den meisten Fällen hervorragend funktionierte.

Mit CSS kommt der Agent auch klar.

Test 1: Feature-Erweiterung für eine Browser-Extension

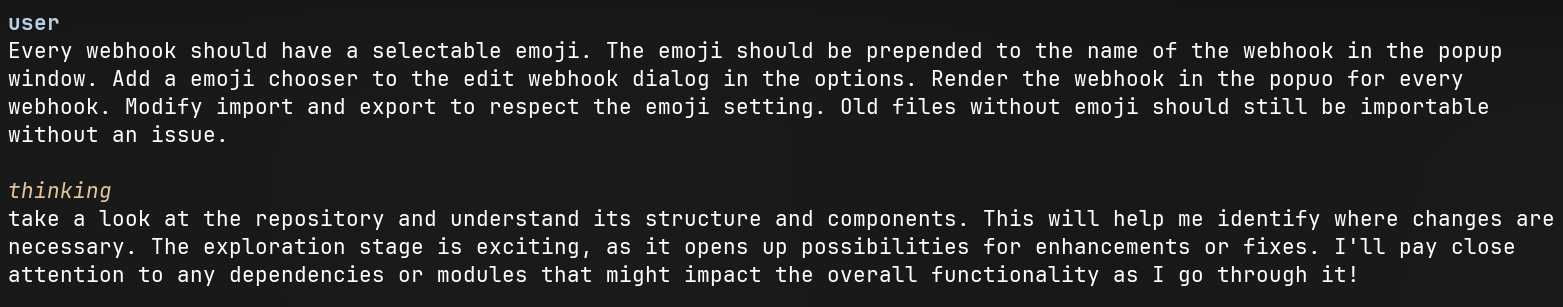

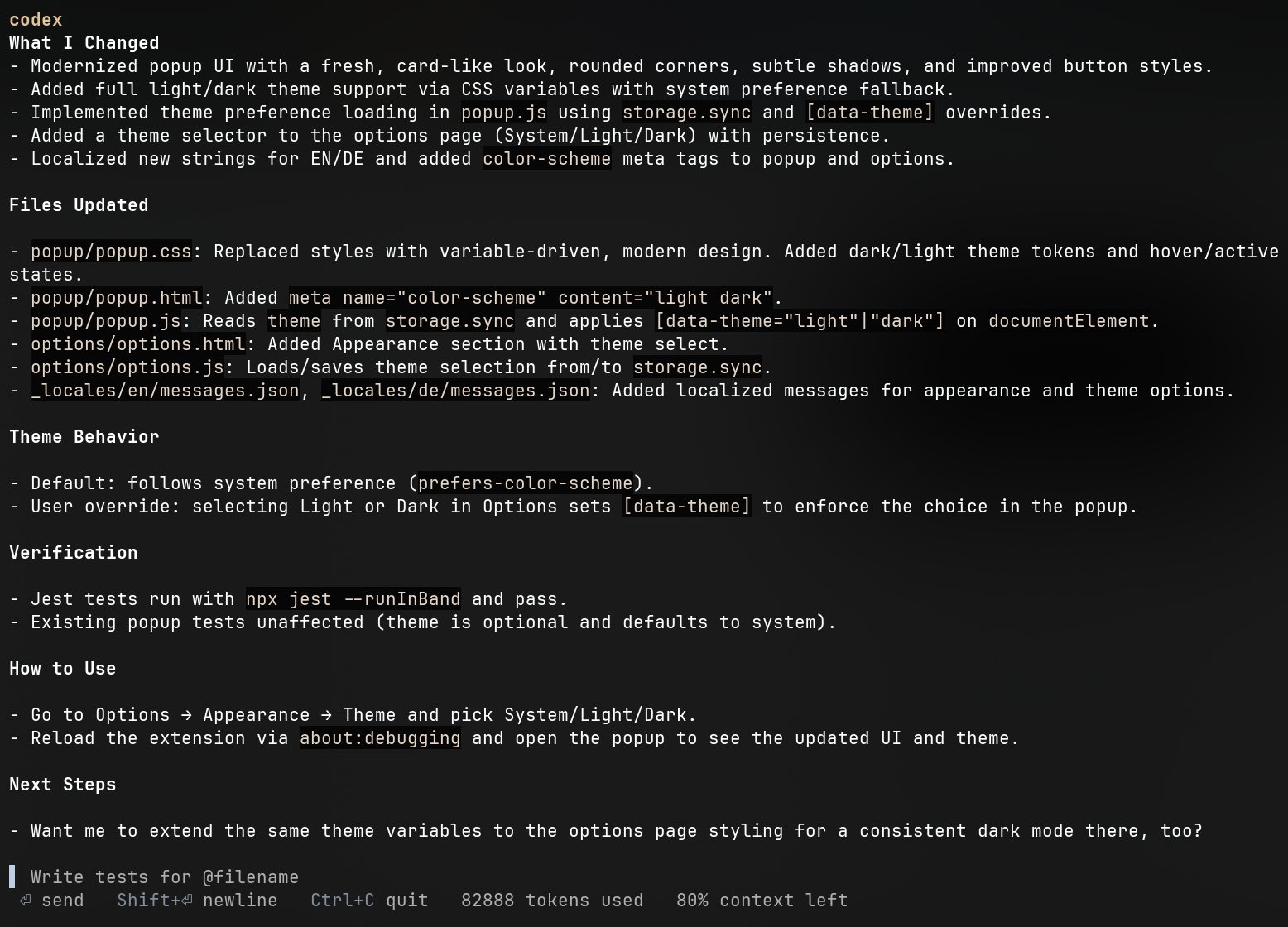

Meine erste Aufgabe für den Agenten war die Erweiterung einer Browser-Extension. Es sollte eine Theme-Auswahl (Light/Dark/System) und ein Emoji-Selektor für konfigurierbare Webhook-Calls implementiert werden.

Das Ergebnis war beeindruckend. Die Funktionalität wurde fast auf Anhieb korrekt umgesetzt. Da in meiner AGENTS.md das Erstellen und Anpassen von Tests gefordert wird, hat der Agent selbstständig bestehende Tests angepasst und neue Testfälle ergänzt. Kleinere Abweichungen von meiner Vorstellung, die ich nicht explizit im Prompt definiert hatte, konnte ich in der gleichen Session per Folge-Prompt korrigieren lassen. Am Ende hatte ich umfangreiche Änderungen an einer bestehenden Software, ohne eine einzige Zeile Code selbst geschrieben zu haben.

Test 2: Liveticker-Software im Mono-Repo

Im zweiten Test wollte ich die Liveticker-Software meines Fußballvereins anpassen. Das Ziel: Pro Spiel sollten Aufstellungen inklusive Rückennummern gepflegt werden können. Ein Klick auf einen Spielernamen sollte diesen dann automatisch in das Kommentarfeld des Tickers einfügen.

Die Herausforderung hierbei war die Architektur: ein Mono-Repo mit einem Go-Backend (API) und zwei separaten JavaScript-Anwendungen für Frontend und Adminbereich. Auch hier überzeugte Codex auf ganzer Linie. Der Agent hatte keine Probleme damit, in einer einzigen Session anwendungsübergreifend im Mono-Repo zu arbeiten. Die Idee für das Feature kam mir etwa drei Stunden vor dem nächsten Liveticker-Event – und dank Codex konnte ich alles in weniger als drei Stunden umsetzen und erfolgreich in Betrieb nehmen.

Fazit

Codex CLI hat sich als extrem leistungsfähiges Werkzeug erwiesen. Die Möglichkeit, einen so fähigen KI-Agenten lokal und direkt im Terminal auf die eigenen Projekte loszulassen, ist ein gewaltiger Fortschritt. Die Kombination aus der einfachen Bedienung, der intelligenten Arbeitsweise und der Power des GPT-5-Modells hat mich vollständig überzeugt. Für mich ist Codex CLI mehr als nur ein Helfer – es ist ein echter Co-Pilot, der die Softwareentwicklung beschleunigt und qualitativ verbessert.

Auch die Effiziente Context-Verwaltung hat mich überzeugt.

Das sieht man auch gut in den Statistiken.